En un artículo publicado recientemente en Biología PLoSLos investigadores reconstruyeron una pieza musical a partir de grabaciones neuronales utilizando modelos computacionales mientras investigaban la dinámica neuronal espacial que sustenta la percepción musical utilizando modelos de codificación y análisis de ablación.

Estancia: La música se puede reconstruir a partir de la actividad de la corteza auditiva humana utilizando modelos de decodificación no lineales. Crédito de la imagen: LianLeonte/Shutterstock

fondo

La música, una experiencia humana universal, activa muchas de las mismas áreas del cerebro que el habla. Los investigadores de neurociencia han seguido las bases neuronales de la percepción musical durante muchos años y han identificado distintos correlatos neuronales de elementos musicales, incluidos el timbre, la melodía, la armonía, el tono y el ritmo. Sin embargo, todavía no está claro cómo interactúan estas redes neuronales para procesar la complejidad de la música.

«Una cosa para mí acerca de la música es que tiene prosodia (ritmos y tonos) y contenido emocional. A medida que avanza el campo de las interfaces cerebro-máquina, esta investigación podría ayudar a añadir musicalidad a futuros implantes cerebrales para personas con discapacidad», explica. Trastornos neurológicos o del desarrollo que afectan el habla”.

-doctor. Robert Knight, Universidad de California, Berkeley

Sobre el estudio

En el estudio actual, los investigadores utilizaron la reconstrucción de estímulos para examinar cómo el cerebro procesa la música. Implantaron 2.668 electrodos de electrocorticografía (ECoG) en 29 superficies corticales de un paciente neuroquirúrgico (el cerebro) para registrar la actividad neuronal o recopilar datos de electroencefalografía (iEEG) mientras escuchaban pasivamente un extracto de tres minutos de la canción de Pink Floyd: “Another Brick”. En la pared, primera parte.

El uso de la escucha pasiva como método de presentación de estímulos evita la confusión del procesamiento neuronal de la música con la actividad motora y la toma de decisiones.

Basándose en los datos de los electrodos 347/2668, reconstruyeron la canción, que se parecía mucho a la canción original, aunque con menos detalles; por ejemplo, las palabras de la canción reconstruida eran mucho menos claras. Específicamente, implementaron modelos de decodificación basados en regresión para reconstruir con precisión este estímulo auditivo (en este caso, un extracto de una canción de tres minutos) a partir de la actividad neuronal.

En el pasado, los investigadores han utilizado métodos similares para reconstruir el habla a partir de la actividad cerebral; Sin embargo, esta es la primera vez que intentan reconstruir la música utilizando este enfoque.

iEEG tiene una alta resolución temporal y una excelente relación señal-ruido. Proporciona acceso directo a la actividad de alta frecuencia (HFA), un indicador de actividad neuronal no oscilatoria que refleja el procesamiento de información local.

Asimismo, los modelos no lineales de decodificación de la corteza auditiva y sensoriomotora proporcionaron la mayor precisión de decodificación y una capacidad notable para reconstruir el habla inteligible. Por lo tanto, el equipo combinó iEEG y modelos de decodificación no lineal para revelar la dinámica neuronal subyacente a la percepción musical.

El equipo también midió el efecto de la duración del conjunto de datos y la densidad de los electrodos sobre la precisión de la reconstrucción.

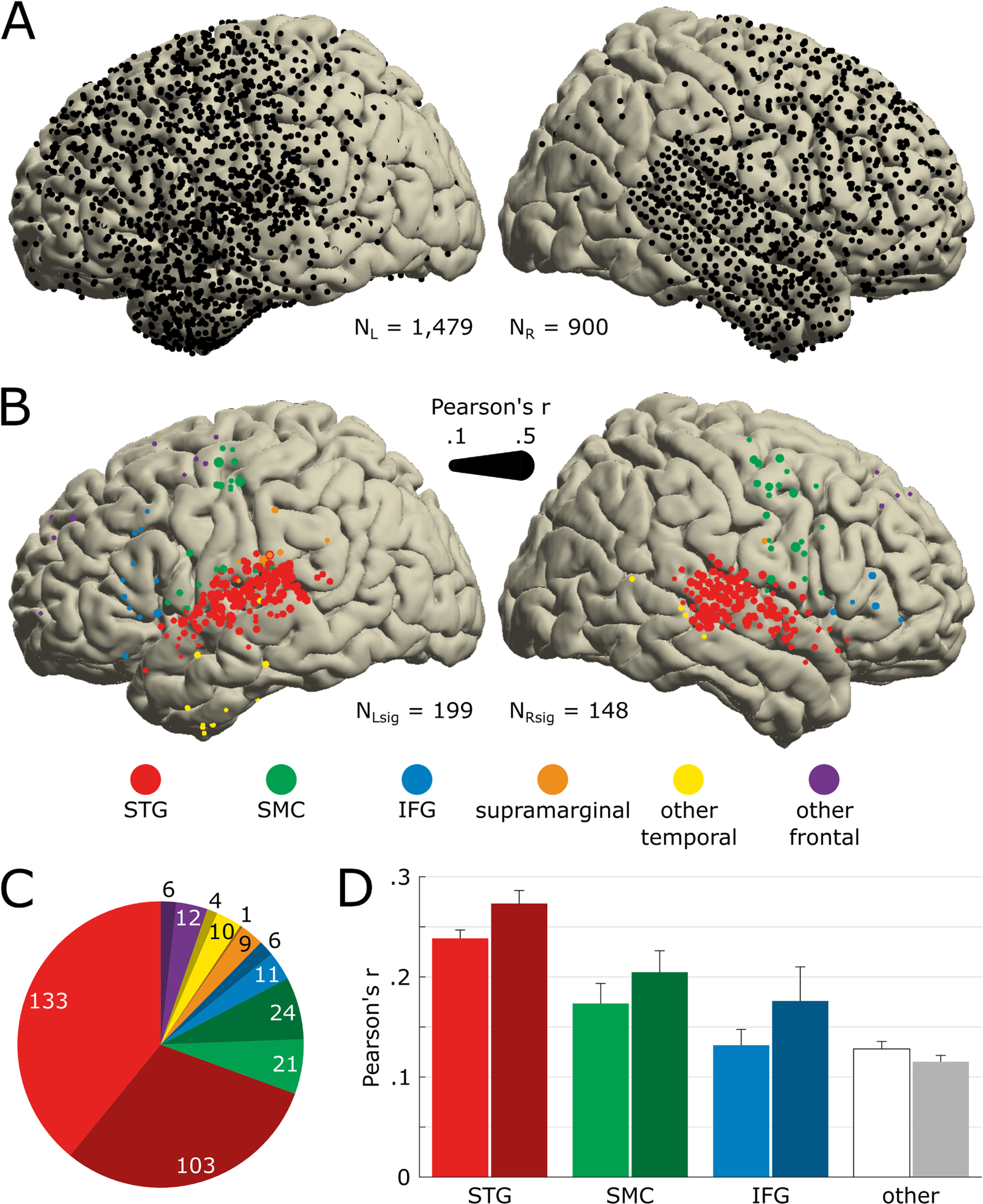

Ubicación anatómica de los electrodos que responden a la canción.a) Cobertura de electrodos para los 29 pacientes que se muestran en la plantilla MNI (n=2379). Todos los electrodos proporcionados están libres de cualquier actividad artificial o epiléptica. El hemisferio izquierdo está dibujado a la izquierda. (B) Ubicación de los electrodos que codifican significativamente la acústica de la canción (NSabio = 347). La importancia se determinó mediante la precisión de las predicciones STRF iniciadas en más de 250 muestras de los conjuntos de entrenamiento, validación y prueba. El color del marcador indica la nomenclatura anatómica determinada utilizando el atlas FreeSurfer, y el tamaño del marcador indica la precisión de las predicciones STRF (coeficiente de Pearson entre HFA real y previsto). Usamos el mismo código de color en los siguientes paneles y figuras. (C) Número de electrodos significativos por región anatómica. El color oscuro indica la ubicación en el hemisferio derecho. (Dr) Precisión promedio de predicción de STRF para cada región anatómica. Los electrodos previamente clasificados como supramarginales, otros electrodos temporales (es decir, distintos de STG) y otros electrodos frontales (es decir, distintos de SMC o IFG) se agrupan, se etiquetan como otros y se representan en blanco/gris. Las barras de error indican SEM. Los datos detrás de este número se pueden encontrar en https://doi.org/10.5281/zenodo.7876019. HFA, actividad de alta frecuencia; IFG, circunvolución frontal inferior. MNI, Instituto Neurológico de Montreal; SEM: error estándar de la media; SMC, corteza sensoriomotora. STG, giro temporal superior; STRF significa Campo receptivo temporal espectral.https://doi.org/10.1371/journal.pbio.3002176.g002

resultados

Los resultados del estudio mostraron que ambos hemisferios del cerebro estaban involucrados en el procesamiento de la música, y que la circunvolución temporal superior (STG) en el hemisferio derecho desempeñaba un papel más importante en la percepción musical. Además, aunque los lóbulos temporal y frontal estaban activos durante la percepción musical, la nueva subregión STG estaba sintonizada con el ritmo musical.

Los datos de 347 de los casi 2700 electrodos ECoG ayudaron a los investigadores a descubrir la codificación musical. Los datos mostraron que ambos hemisferios del cerebro estaban involucrados en el procesamiento de la música, con electrodos en el hemisferio derecho respondiendo más activamente a la música que el hemisferio izquierdo (16,4% frente a 13,5%), un hallazgo en contraste directo con el habla. Vale la pena señalar que el habla provoca respuestas más importantes en el hemisferio izquierdo del cerebro.

Sin embargo, en ambos hemisferios, la mayoría de los electrodos sensibles a la música se implantaron en un área llamada giro temporal superior (STG), lo que sugiere que probablemente desempeñaron un papel crucial en la percepción musical. El STG se encuentra justo encima y detrás de la oreja.

Además, los resultados del estudio mostraron que los modelos no lineales proporcionaron la mayor precisión de decodificación, r cuadrado, del 42,9%. Sin embargo, agregar electrodos más allá de cierta cantidad también reduce la precisión de la decodificación; Por lo tanto, retirar los 43 electrodos de ritmo correctos redujo la precisión de la decodificación.

Los electrodos incluidos en el modelo de decodificación tenían características funcionales y anatómicas únicas, que también afectaron la precisión de decodificación del modelo.

Finalmente, con respecto al efecto de la duración del conjunto de datos en la precisión de la decodificación, los autores señalan que el modelo logró el 80% de la precisión de decodificación máxima observada en 37 segundos. Este resultado subraya el uso de métodos de modelado predictivo (como los utilizados en este estudio) en pequeños conjuntos de datos.

Los datos del estudio podrían tener implicaciones para las aplicaciones de interfaz cerebro-computadora (BCI), por ejemplo, herramientas de comunicación para personas con discapacidades que tienen problemas del habla. Debido a que la tecnología BCI es relativamente nueva, las interfaces basadas en BCI disponibles generan voz con una calidad robótica y antinatural, que puede mejorar con la incorporación de elementos musicales. Además, los resultados del estudio podrían ser clínicamente relevantes para pacientes con trastornos del procesamiento auditivo.

Conclusión

Nuestros resultados confirman y amplían hallazgos anteriores sobre la percepción musical, incluida la dependencia de la percepción musical de una red bilateral con el lado derecho. Dentro de la distribución espacial de la información musical, los componentes redundantes y únicos se distribuyeron entre el STG, la circunvolución temporal media (SMC) y la circunvolución frontal inferior (IFG) en el hemisferio izquierdo y se concentraron en el STG en el hemisferio derecho, respectivamente.

Las investigaciones futuras podrían tener como objetivo ampliar la cobertura de los electrodos a otras áreas corticales, cambiar las características de los modelos de decodificación no lineales e incluso agregar una dimensión conductual.

«Adicto a la televisión incondicional. Empollón del alcohol. Fanático del café sutilmente encantador. Amante de la música».

More Stories

Ellen DeGeneres habla sobre el final 'devastador' del programa de entrevistas: Informes

El presentador de 'Survivor', Jeff Probst, dice que en la temporada 50 todos los jugadores regresarán

El acosador de 'Baby Reindeer' en la vida real habla después de la emisión del programa de Netflix